국내 연구진이 데이터센터 네트워크 전송 버퍼를 12분의 1로 줄여서 전송 속도를 3~4배 빠르게 하는 기술을 개발했다.

KAIST(총장 신성철) 한동수 전기 및 전자공학부 교수팀과 장건 구글 연구원은 데이터 전달 절차를 개선해서 데이터 전송 속도를 끌어올린 새로운 네트워크 혼잡 제어 시스템 기술을 공동 개발했다고 12일 밝혔다.

네트워크 전송 지연 문제는 데이터센터, 웹 서비스 호스팅 기업의 오랜 숙제다. 네트워크 회선이 혼잡해지고 서비스 이용자가 늘면서 데이터 양이 급증하기 때문이다. 데이터센터는 네트워크 대역폭을 늘리는 방식으로 지연 현상을 줄이려 했지만 '전송제어 프로토콜(TCP·데이터 전송을 위한 규칙과 절차)' 한계 때문에 큰 효과를 보지 못했다.

기존의 데이터센터 TCP는 '버퍼'를 이용해 정보 전송 요청을 제어한다. 버퍼는 네트워크 회선에 다수 존재하는 임시 기억 장소다. 경유하는 패킷을 저장, 회선 혼잡도를 파악·제어하는 역할을 한다. 버퍼가 가득차면 전송 패킷 양을 줄여 회선 과부하를 막고, 가득 차지 않으면 점차 패킷 양을 늘려서 전송 속도를 높이는 식이다. 버퍼에 데이터가 저장되는 과정에서 지연 시간이 늘어날 수밖에 없다. 버퍼 크기가 클수록 전송 지연 시간도 늘어난다.

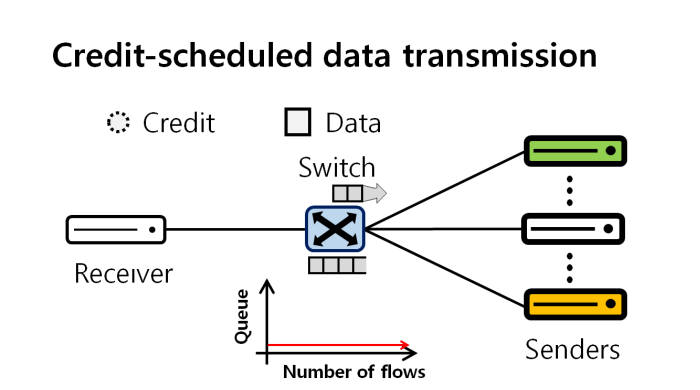

연구팀은 데이터 전송 전 네트워크 회선에 혼잡도 탐지 역할을 하는 '크레디트 패킷'을 왕복시키는 방법을 적용했다. 크레디트 패킷은 보통 패킷의 5% 크기다. 빠르게 회선 혼잡도를 탐지해서 적절한 데이터 전송량, 전송 순서를 계산한다. 데이터센터 네트워크 버퍼 사용량을 기존의 12분의 1 수준으로 대폭 줄였다.

이 기술을 적용하면 10kB 미만의 데이터를 기준으로 3~4배 빠른 전송 속도를 구현할 수 있다. 데이터센터에 적용하는 것도 간단하다. 네트워크 호스트에 소프트웨어(SW)를 업데이트하고, 간단한 설정을 추가하는 것만으로 쉽게 적용할 수 있다.

KAIST는 이 기술을 지난달 24일 미국에서 열린 컴퓨터 네트워킹 분야의 최고 권위 학술대회인 시그컴(SIGCOMM)에 소개, 구글·화웨이 등 대규모 데이터센터 활용 기업으로부터 큰 관심을 받았다.

한동수 교수는 “전송 지연 현상을 줄이는 연구는 연구 난도가 높아서 큰 성과를 내기 어려운 분야”라면서 “새로운 네트워크 혼잡 제어 시스템 기술은 업계 발전과 이익 창출에 새로운 장을 열어 줄 것”이라고 의의를 부여했다.

대전=김영준기자 kyj85@etnews.com