인공지능(AI) 작가 시대가 열렸다. AI의 글은 뛰어난 문학 작품에 비할 바는 못 되지만 적어도 사람이 쓴 것처럼 흉내를 낸다. 이제는 글의 저자가 기계인지, 사람인지 구분조차 어려운 상황이 됐다.

AI가 글의 영역에 침투하면서 문제가 생겼다. 허위 내용의 뉴스나 칼럼 등에 AI가 동원돼 피해가 늘고 있다는 것. 사람이 직접 쓴 것처럼 위장한 이러한 글을 식별하는 것은 쉽지 않다.

이를 해결할 좋은 방법이 없을까? 이에 대해 최근 흥미로운 연구가 진행 중이다. 'AI로 AI가 쓴 글을 찾아내는 방법'인데, MIT테크놀로지리뷰는 하버드대와 MIT-IBM 왓슨 AI 랩 연구팀이 '거대언어모델실험실(Giant Language Model Test Room·GLTR)'을 만들었다고 보도했다.

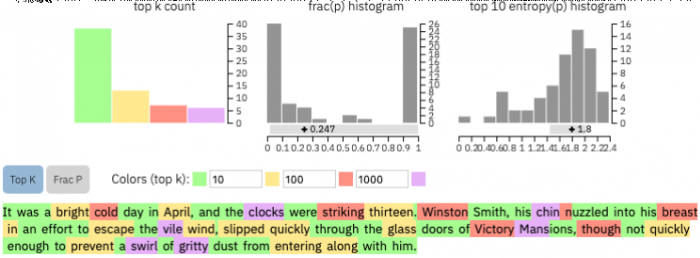

GLTR은 AI가 텍스트의 실제 의미보다는 텍스트에 자주 등장하는 표현에서 패턴을 찾아 글을 쓴다는 점에서 착안, AI가 쓴 글을 식별해낸다. 예컨대 한 단락의 글에서 사용된 단어가 모두 '예측 가능'하다면 이 글은 사람이 아닌 AI가 썼을 가능성이 매우 높다.

이 기술은 연구팀이 단독으로 개발한 게 아니다. GLTR은 지난 2월 비영리 AI 연구단체 '오픈AI(OpenAI)'가 내놓은 'GPT2'를 참고해 만들어졌다. GPT2는 축적된 데이터를 바탕으로 글을 쓰는 AI다. GPT2는 단어 사용빈도, 함께 쓰이는 단어 조합 등을 산출한 뒤 이를 토대로 글을 생성한다. 오픈AI는 가짜뉴스 등 부작용을 우려해 GPT2 연구 결과를 외부에 공개하진 않은 상태다. 다만 오픈AI가 공개한 일부 코드는 GLMT를 구축하는 데 도움을 줬다.〃

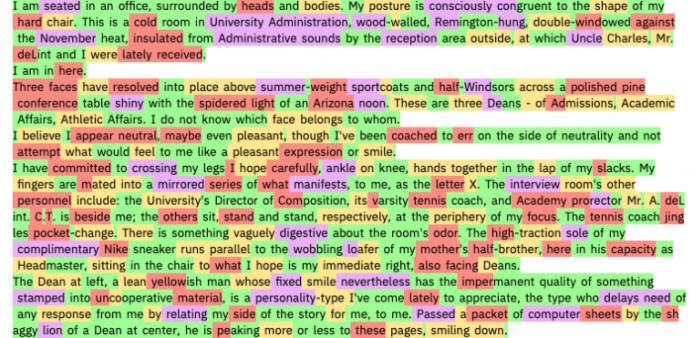

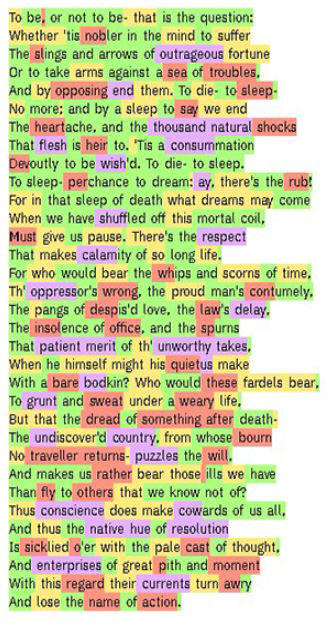

GLMT도 GPT2와 비슷한 방식으로 AI가 쓴 글을 골라낸다. 먼저 단어 사용빈도를 분석해 흔히 볼 수 있는 단어 조합을 찾는다. 그 다음 가장 예측이 쉬운 단어는 초록색, 가장 예측이 어려운 단어는 보라색으로 구분한다. 예측이 비교적 쉬운 건 노란색, 예측이 비교적 어려운 건 빨간색이다.

GLMT를 활용해 GPT2가 생성한 AI 글을 분석하면 단어 대부분이 초록색으로 표시된다. AI가 쓴 글이라는 걸 정확히 짚어냈다는 뜻이다.

그렇다면 유명 문학작품을 GLMT로 검사해보면 어떤 결과가 나올까?〃

다음은 셰익스피어의 '햄릿' 일부분이다. 빨간색과 보라색 표시가 눈에 많이 띈다. 첫번째 보라색 표시가 된 단어 'outrageous'는 outrage(분노, 포학)의 형용사로 '매우 충격적인', '잔학무도한'이란 의미를 가진다. 그리 생소한 단어는 아니지만 뒤에 명사 'fortune(운명)'을 수식하는 건 보기 드물다. 즉 'outrageous fortune'란 단어 조합이 AI의 예측을 벗어난다는 얘기다.〃

영국 소설가 조지 오웰의 작품 '1984'도 위와 비슷한 결과가 나온다. 보라색과 빨간색으로 된 단어가 다수 확인된다.

연구팀은 또 다른 실험을 했다. 하버드 학생들을 GLTR을 사용하는 그룹과 사용하지 않는 그룹으로 나눈 뒤 학생들이 AI가 쓴 허위 글을 얼마나 찾아낼 수 있는지 관찰했다. 실험 결과 GLTR 비사용 그룹은 허위 글 중 50%를 색출한 반면, GLTR 사용 그룹은 72%를 골라냈다. 사람과 AI가 협력하면 가짜 글을 찾는 데 더 효과적이라는 분석이다.

MIT 테크놀로지리뷰는 "허위 내용을 담은 글과 이미지 등을 만드는 기술이 빠르게 발전하고 있다"며 "GLTR을 이용하면 가짜뉴스, 딥페이크, 트위터 봇 등을 판별하고 처리하는 데 큰 도움이 될 것"이라고 말했다.

권선아기자 sunak@etnews.com