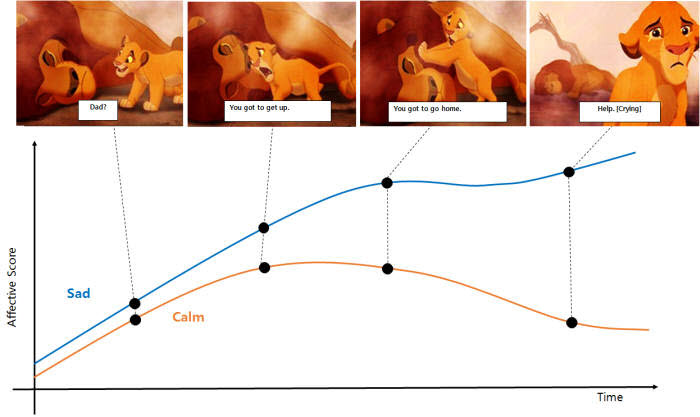

관련 통계자료 다운로드 '딥러닝 기반 인간 감정 파악시스템'의 감정 분간 모델 도식화한 그래프

관련 통계자료 다운로드 '딥러닝 기반 인간 감정 파악시스템'의 감정 분간 모델 도식화한 그래프

사람과 인공지능(AI)의 상호작용은 날이 갈수록 발전하고 있다. 이용자에게 갖가지 맞춤형 편의를 제공해주는 것이 가능해졌다. 단순히 원하는 값이나 분석 결과를 제시해주는 것에서 벗어나 소통한다. 사람은 그 이후, '감성적인 상호작용'이 가능한 AI를 바라고 있다. 내 감정을 이해하고 반응하는 '인공감성지능(AEI:Artificial Emotional Intelligence)' 구현이 새로운 목표로 떠오르고 있다. 물론 AI에 사람과 같은 실제 감성을 부여하는 것은 먼 훗날에도 기약할 수 없는 일이다. 다만 AI 나름의 방식으로 이를 이해하고, 대응하게 하는 것은 상대적으로 쉽다.

이를 학문으로 다루기 시작한 시점이 1990년대 중반의 '감성 컴퓨팅(AC:Affective Computing)'이다. 얼굴 표정이나 자세·움직임은 물론이고 심박 수, 뇌 활동과 같은 생리신호를 분석하고 대상이 느끼는 감정 상태를 인식하는 것이 주된 연구 방향이었다. 이후 기계학습·딥러닝 기술이 발전하면서 보다 많은 정보에서 감정을 읽어낼 수 있고 AEI 기술이 태동하게 됐다.

고도화된 인식 기능을 활용해 도구나 환경이 사용자 감정에 맞춰 동작하도록 하는 것이 첫 번째 분야다. 명령을 주고받는 것이 아니라 AI가 스스로 이용자 감정을 인식·대응하는 것이 핵심이다.

조성호·김병형 한국과학기술원(KAIST) 전산학부 교수가 이 분야에서 활약하고 있다. 이미 장치로 뇌전도(EEG), 심박수를 검출해 사람의 12개 감정 상태를 구분하는 기술을 개발했다. '감성 피드백'을 적용해 각종 도구나 환경 동작에 완성도를 더하는 연구도 진행되고 있다. 어떤 AI의 행동에 이용자가 언짢은 감정을 느끼면, 이를 학습해 피하는 식이다. 조성호 교수는 “감성을 AI에 더하면 단순히 명령을 주고받는 관계에서 벗어나, 마치 하나인 것처럼 '기계적인 나'가 돼, 일을 수행할 수 있게 된다”며 “감성 피드백으로 AI가 더욱 세밀해지고 고도화될 수 있다”고 설명했다.

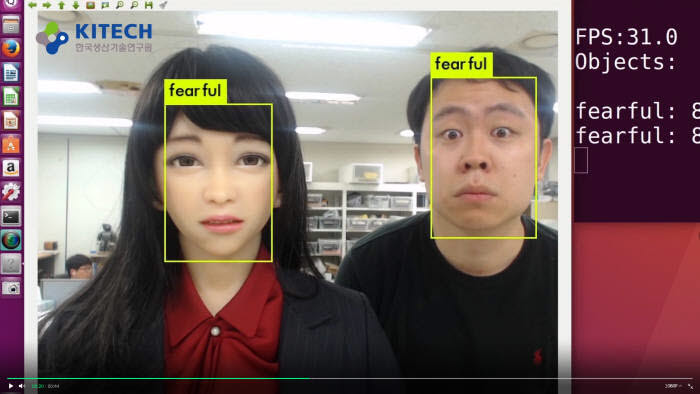

사람의 감성을 AI 산물에 '입히는' 연구도 활발하다. 비록 흉내일지라도 AI가 이용자 감정에 즉각, 세밀하게 대응한다면 더욱 원활한 소통이 가능해지기 때문이다. 대표 사례로 한국생산기술연구원이 개발 중인 '에버'를 들 수 있다. 에버는 표정으로 세밀한 감정을 표현하는 로봇이다. 지난해 말 구현한 '에버-6'의 경우 26개 모터(액추에이터)를 활용해 12개 이상 표정을 지을 수 있다.

표정은 감성적인 상호작용 결과다. 다양한 각도의 다수 얼굴에서 6개 감정을 동시 인식해 이것에 맞춘 표정을 지어준다. 사람이 웃으면 에버가 함께 웃어주는 식이다. 이동욱 생기원 박사는 “아직까지 로봇은 실제 대화한다는 느낌을 주지 못해 소통에 거부감이 든다”며 “자연스러운 대화와 표정, 제스처, 시선 등을 통해 로봇이 감정을 표현할 수 있게 하는 것은 AEI의 가장 직접적 형태”라고 말했다.

AEI는 산업 분야에 적용되고 있다. 감정을 모사하는 로봇은 물론이고 자동차와 운전자가 교감하는 감성 주행, 감정을 분석해 콘텐츠를 추천하는 고객 지원 서비스 산업 등에 활용되고 있다. 김선희 고려대 뇌공학과 교수는 “AEI는 앞으로 더욱 크게 성장할 것”이라며 “여러 산업 분야에서 AEI 기술을 효과적으로 통합한다면, 기술경쟁에서 선두 주자에 서게 될 것”이라고 말했다.

<표>주요 분야별 AEI 기술 (자료:김선희 고려대 교수)

대전=김영준기자 kyj85@etnews.com

![[AI 사피엔스 시대]'AI가 느낀다'...감성 이해·대응하는 'AEI'](https://img.etnews.com/photonews/2006/1315122_20200630110951_124_T0001_550.png)