관련 통계자료 다운로드 IBM이 구분한 네 가지 웃음 유형

관련 통계자료 다운로드 IBM이 구분한 네 가지 웃음 유형

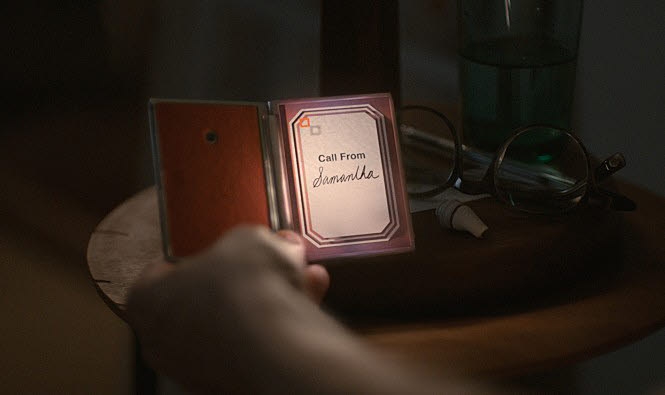

영화 '허(her)' 남자 주인공은 여성 목소리를 지닌 인공지능(AI) 운용체계(OS) '사만다'와 사랑에 빠진다. 사만다는 남자 주인공이 데이트에 실패하고 돌아오자 기분을 풀어주기 위한 이야기와 음악을 전한다. 사만다가 주인공을 위로할 수 있었던 것은 그의 목소리 톤과 대화 속 담긴 단어 속에서 다양한 감정을 읽었기 때문이다.

감정을 읽는 AI는 아직 영화처럼 드라마틱하게 발전하지 않았다. 하지만 다양한 시도와 기술 개발이 한창이다.

IBM은 2019년 국제전기전자공학회 신호처리국제학술대회에서 AI가 대화 속 웃음을 판별한다는 사실을 입증했다.

감정을 읽는 AI는 대량 데이터 분석이 중요하다. 데이터 속에서 패턴을 읽고 의미를 파악한다. 웃음 판별 AI도 마찬가지다. IBM은 대화 속 사용된 웃음 종류와 그 속에 숨겨진 의미를 파악하는 데 주력했다.

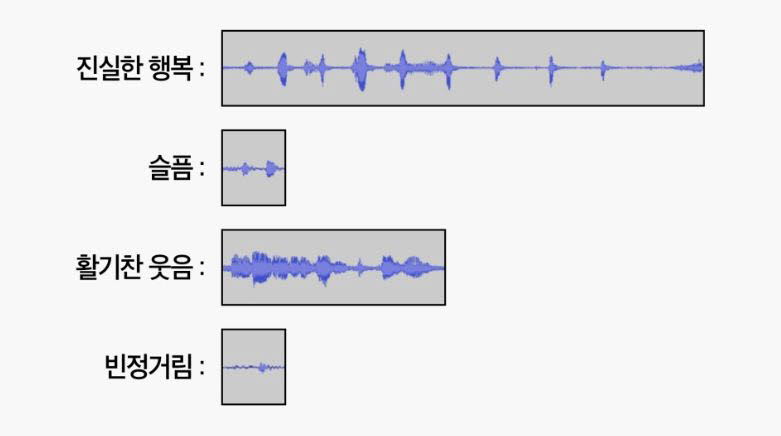

IBM은 대화 속에서 말소리와 웃음소리를 구분하는 데 초점을 맞췄다. AI가 무엇이 말이고 웃음인지 구분하도록 학습시켰다. 이를 위해 1200명 이상 지원자로부터 120여가지 웃음 관련 사례를 수집했다. 여기에 컴퓨터 언어분석기법을 적용, 총 12가지 주요 웃음 패턴을 발견했다. 웃음이 진짜 웃음인지 아닌지도 구분했다.

IBM은 웃음 속에도 △진실한 행복 △슬픔 △활기찬 웃음 △빈정거림 네 가지로 구분된다는 사실을 발견했다. 연구 결과를 바탕으로 웃음 관련 연구를 확대 중이다. 웃음뿐 아니라 다양한 비언어적 의사소통이 어떤 감정을 내포하는지 확대 연구한다.

우리나라에서도 사람 몸에서 검출한 생체 신호와 행동을 기반으로 감정을 파악하는 AI 기술이 개발됐다.

조성호 KAIST 전산학부 교수와 김병형 연구교수팀은 생체 신호를 딥러닝 기술로 분석하는 감정 파악시스템과 감정·행동을 연계해 사람 감정과 인과관계를 나타내는 수식화 알고리즘을 지난해 개발했다.

감정 파악 시스템은 뇌 전두엽에서 발생하는 뇌전도와 심장 박동 신호를 딥러닝으로 분석한다. 행복, 흥분, 기쁨, 슬픔, 지루함 등 12가지 감정을 구분한다. 이 감정 상태를 실제 사용자 행동과 연관시켰다. 카메라로 파악한 사용자 행동이 감정 변화에 어떻게 영향을 미치는지 살폈다. 이를 종합해 감정과 행동을 연계해 인과관계를 수식화한 알고리즘을 개발했다.

연구팀은 알고리즘 기반으로 심리치료나 행동 발달 교정 등 헬스케어 분야에서 주로 사용될 것으로 전망한다. 기존에는 생체 신호로 사람 감정 파악에 주력했지만 사람 행동까지 고려한 연구 결과여서 홈케어 서비스에서도 활용이 기대된다.

감정 AI는 데이터 분석이 중요하다. 대기업은 다양한 데이터를 구매해 분석 가능하지만 스타트업이나 중소기업은 데이터가 부족해 기술개발이 어려운 때가 많다.

정부도 감정 관련 데이터 수급 어려움에 공감해 지난해부터 음성, 대화 등 감정 관련 데이터를 대량 공개했다. △이상행동 영상 △감정·상황·대화 내용을 담은 복합 영상 데이터 △한국어 음성 데이터 등 2500여만건 데이터셋을 공개한다.

NIA는 “개방한 데이터셋을 활용하면 사람 표정과 대화 속 내포된 감정을 읽고 공감하며 대화하는 AI로봇 등 새로운 서비스 개발에 도움될 것”이라면서 “참신한 아이디어를 보유한 스타트업이 데이터를 활용해 말과 감성을 이해하는 AI 개발에 일조할 것”이라고 기대했다.

김지선기자 river@etnews.com