정보를 주고받는 수단인 '미디어'는 정보통신기술(ICT) 핵심 요소다. 실감나는 콘텐츠로 색다른 경험을 주거나 일목요연한 정보 전달을 돕기도 한다. 과학기술정보통신부(장관 이종호), 정보통신기획평가원(IITP·원장 전성배) 지원으로 마련된 '2022 국가 연구개발(R&D) 우수성과 100선' 내 ICT 성과에서 이를 확인할 수 있다.

서정일 한국전자통신연구원(ETRI) 실감미디어연구실장팀이 개발한 '초실감 메타버스 서비스를 위한 이머시브 미디어 원천기술'은 메타버스 가상 환경을 더 현실에 가깝게 한다.

연구팀은 다수 카메라 영상을 연결해 8K 3DoF(Degree of Freedom:자유도) 영상을 실시간 생성하는 기술을 개발했다. 3DoF는 고정 위치에서 360도 전방향을 볼 수 있는 움직임 자유도다. 전후좌우 이동하며 전방향을 볼 수 있으면 6DoF다.

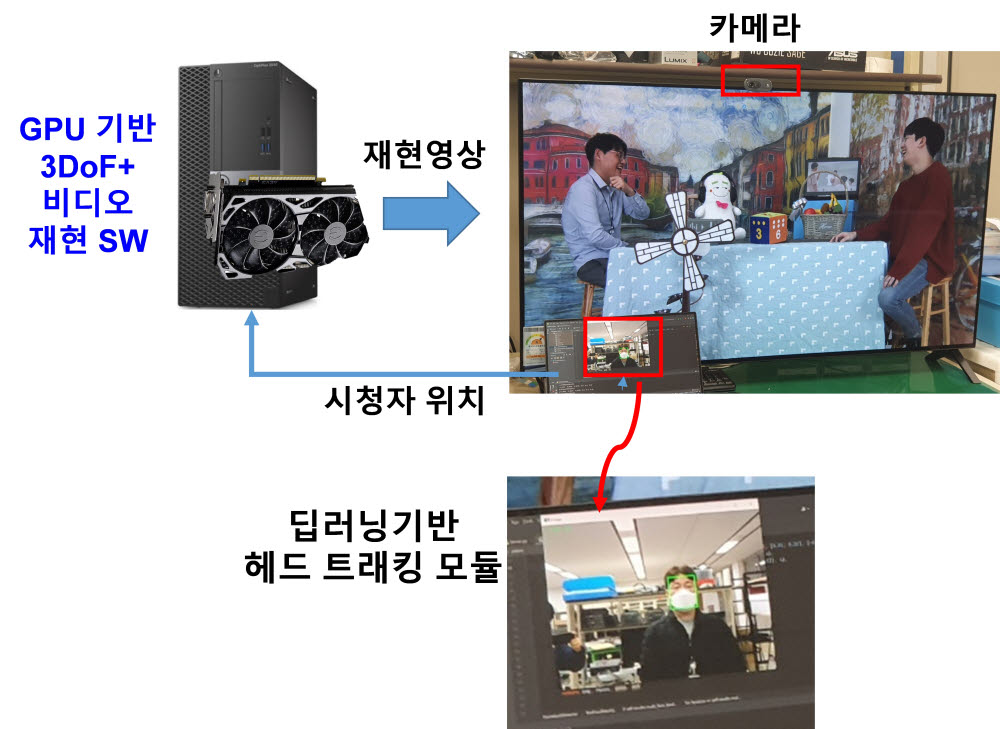

연구팀은 중간 단계로 머리를 움직이는 수준인 ±30㎝ 범위에서 6DoF를 제공하는 3DoF+ 핵심기술도 구현했다. 3DoF+를 사실적으로 구현하려면 영상 속 깊이 정보가 필요하다.

폴란드 포트난대와 픽셀 묶음인 '슈퍼 픽셀'에서 깊이 정보를 효율적으로 추출하는 알고리즘, 여러 대 카메라에서 얻은 영상의 중복을 효과적으로 제거하는 '푸르닝 알고리즘'도 개발했다.

이들 기술의 우수성은 세계적으로 인정받고 있다. 국제특허 3건 등록, 과학기술논문색인확장판(SCIE)급 논문 4건 발표 등을 이뤘고 표준화 성과로 이미 18건 이상 표준특허를 확보했다.

서정일 실장은 “미래 미디어 서비스 원천기술을 개발, 국제 표준 분야에서 이름 알린 것이 뜻 깊다”며 “우리나라가 향후 초실감 메타버스 구현에 앞장설 때 큰 도움이 될 것”이라고 말했다.

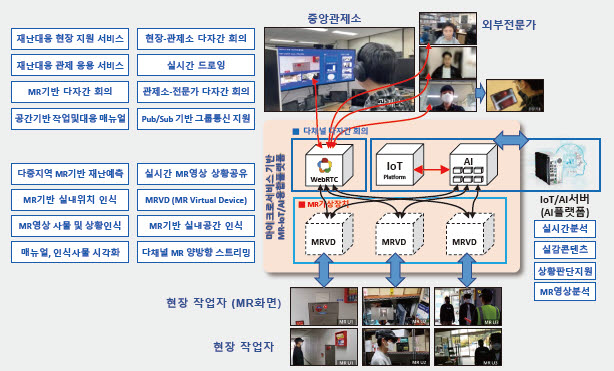

노병희 아주대 교수팀은 '혼합현실(MR)-사물인터넷(IoT), 인공지능(AI) 융합 플랫폼 기반 실감 몰입형 협업 시스템'을 개발, 국가 R&D 우수성과 100선에 이름을 올렸다.

이 기술은 재난 상황에서 현장과 중앙관제센터, 외부 등 전 영역을 잇는 플랫폼이다. 현장 대응 요원이 홀로렌즈(MR) 장치로 재난 정보를 실시간 수집할 수 있다. 현장 주변 IoT 기기에서도 정보를 얻는다. AI 기술로 왜곡된 현장 영상을 복원하는 기술도 가미했다.

관제소는 실시간 상황을 분석, 어느 지점이 위험하고 안전한지 판단해 대응을 지원한다. 현장과 관제소, 외부 전문가가 MR 기반 회의를 통해 서로 상황을 공유할 수 있는 협업 시스템도 구현했다. 도시 규모 재난 시뮬레이션 방법, 대응계획 수립 기술도 개발했다.

이들 기술로 이룬 기술이전 성과는 지난 3년간 11개 기업에 12건이다. 연구진은 현재 다양한 멀티모달 정보를 한 곳에 모아 AI 분석 기술을 추가 개발하고 있다.

노병희 교수는 “이번에는 재난대응에 초점을 뒀지만 개발 기술은 국방 감시정찰이나 디지털 트윈 산업 현장에서도 사용 가능하다”며 “응용 범위가 상당하다”고 말했다.

김영준기자 kyj85@etnews.com