Llama2, 스테이블 디퓨전(Stable Diffusion)과 같은 상용 오픈소스 모델이 하루에도 수 십 개씩 공개되고 있으며, GPT-4 와 같이 모델의 크기 또한 커지면서 MLOps의 필요성이 대두되고 있다. 머신러닝 개발자들이 빠르고 쉽게, 비용 효율적으로 AI 모델을 개발, 운영하려는 기업들이 많아지고 있기 때문이다.

'머신러닝'을 뜻하는 ML과 '운영화'를 뜻하는 Ops를 합친 MLOps란 쉽게 말해 AI 챗봇이나 AI 필터 등과 같이 최근 화두가 되고 있는 최신 머신러닝 기반 서비스 개발과 운영에 필요한 툴, 인프라 등을 아우르는 개념이다.

예를 들면 데이터 수집과 준비 과정에서부터, AI 모델을 개발하고, 이를 배포, 운영하는 전 과정에 대한 툴과 인프라를 모두 MLOps라고 하는 것이다. 하지만 이런 MLOps를 구현하는 것이 그리 쉬운 일은 아니다. 우선 머신러닝 모델의 품질은 데이터의 품질에 크게 좌우되기 때문에 데이터의 품질을 보장해야 하며, MLOps는 개발자와 데이터 과학자, 운영 엔지니어 등 여러 분야의 전문가들이 협업할 수 있는 환경을 조성해야 한다. 그리고 ML 모델 개발의 전 과정에 걸친 일련의 과정, 그리고 이런 프로세스를 수행하기 위한 다양한 도구들로 인해 MLOps의 복잡성 문제 또한 대두되고 있기 때문이다.

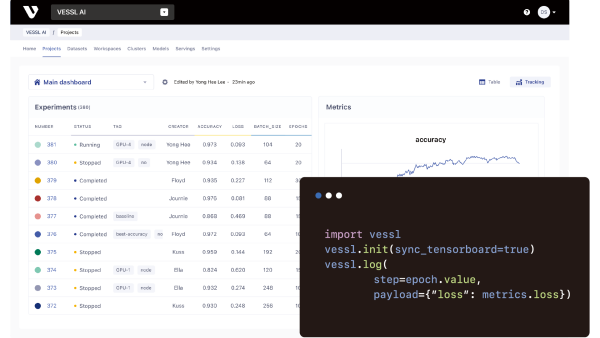

VESSL AI는 기업들이 복잡한 머신러닝 인프라와 파이프라인을 직접 구축하지 않아도 모델을 학습, 배포할 수 있는 SaaS 방식의 MLOps 플랫폼으로, 시각화, 모델과 데이터 버전 관리, 하이퍼파라미터 최적화와 같은 기능을 통해 머신러닝 팀의 효율성을 개선하는 것이 특징이다.

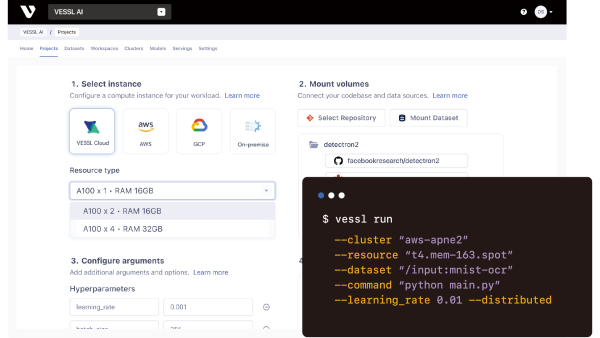

VESSL AI는 머신러닝 전 과정을 간편하게 지원하는 통합 플랫폼으로, 커맨드 한 줄로 최신 모델 지원이 가능하다. 예를 들면 “vessl run” 커맨드 한 줄로 Llama2나 스테이블 디퓨전과 같은 최신 모델을 학습, 튜닝, 배포할 수 있다. 이처럼 간편하게 엔지니어들은 복잡한 과정 없이 최신 기술을 쉽게 실험해보고, 배포수준까지 성능을 끌어올릴 수 있다.

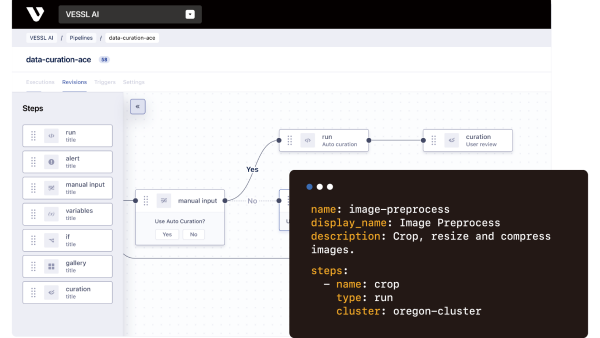

VESSL AI는 머신러닝의 전 과정을 지원한다. 복잡한 과정 없이 VESSL AI 하나로 머신러닝 모델의 학습부터 배포에 이르는 전 과정을 효율적으로 관리할 수 있다. 기존에는 MLOps를 위해 각 과정에 필요한 여러 툴을 서로 연동하는 복잡한 과정이 필요했었다. 하지만 VESSL AI를 사용하면, 이런 과정을 모두 건너 뛰고 엔드투엔드로 MLOps를 구현하기 위한 각종 기능을 사용할 수 있다.

VESSL AI는 최근의 머신러닝 개발, 운영 환경이 클라우드를 기반으로 하고 있는 상황을 고려해, 다양한 클라우드 연동을 지원한다. AWS, GCP, 애저 등 주요 클라우드 플랫폼과 함께 자체 클라우드를 쉽게 연동해 사용할 수 있다. 이같은 클라우드 연동으로 기업들은 인프라의 확장성과 비용 최적화를 동시에 달성할 수 있다.

VESSL AI는 파이프라인, 하이퍼파라미터 최적화, 자원배분 등을 자동화해 반복작업을 줄이고 더 빠르게 모델을 개발, 개선할 수 있어 프로덕션까지 도달하는 데 걸리는 시간을 최대 4배 더 빠르게 진행할 수 있다. 또한 모델이나 데이터, 실험 이력 등을 한 곳에 저장, 관리해 개발 사이클 전반의 가시성과 팀 내 협업을 개선할 수 있어 개발 생산성을 약 20% 증가시킨다.

클라우드 사용을 최적화하고 MLOps 구축에 필요한 자원을 줄여 모델 개발 자체에만 집중할 수 있도록 도와, 개발 비용을 최대 80% 절감할 수 있고, 하이브리드 클러스터를 구축하고 분산학습을 이용해 유휴 자원을 최소화하고 컴퓨팅 자원을 극대화할 수 있어 인프라 활용율을 최대 5배까지 향상시킬 수 있다.

기업의 데이터세트와 GPU 인프라를 활용해 LLM(Large Language Model)을 개발하고자 하는 기업들이 급격히 증가하고 있다. 베슬에이아이는 이런 상황을 고려해 MLOps를 넘어, LLMOps의 영역으로 지원 범위를 확장해 나갈 계획이다.

현재 VESSL AI를 개발한 베슬에이아이는 Llama2 등과 같은 최신 언어 모델을 빠르게 학습, 파인튜닝, 배포할 수 있는 API를 제공하고 있으며, 궁극적으로 기업들이 보안, 비용 걱정 없이 기업 고유의 LLM을 개발할 때 필수적인 AI 인프라로 자리잡고자 한다.

나아가 국내 여러 기업과 기관에 베슬에이아이의 MLOps 플랫폼을 제공한 경험을 발판으로 창업 3년 차를 맞는 베슬에이아이는 국내에서 티맵모빌리티 데이터플랫폼팀, 코그넥스 딥러닝 랩, 스캐터랩 머신러닝팀 등 국내 유수 AI/ML 개발 조직뿐 아니라 KAIST 김재철AI대학원, 서울대 공과대학교, 연세대 인공지능대학원, 원자력연구소 등 여러 대학과 연구실에서도 사용되고 있으며, 이런 국내 시장에서의 경험을 바탕으로 올해부터는 미국으로 시장 확대에 나서고 있다. 올해 미국에서 첫 엔터프라이즈 계약을 맺는 것을 시작으로 북미 시장을 본격적으로 개척해 나갈 예정이다.

전자신문인터넷 유은정 기자 judy6956@etnews.com