한국과학기술원(KAIST·총장 이광형)은 노용만 전기 및 전자공학부 교수팀이 오픈AI의 'GPT-4V'와 구글 '제미나이-프로'를 뛰어넘는 공개형 멀티모달 거대언어모델(LLM)을 개발·출시했다고 20일 밝혔다.

멀티모달 LLM은 텍스트뿐 아니라 이미지 데이터도 처리할 수 있다. 해외 대형 기업은 인간 뇌에 있는 신경망 개수와 유사한 수준으로 이를 만들고 있으나 학계에서는 쉽지 않았다.

연구팀은 단순히 모델 크기를 키우거나 고품질 시각적 지시 조정 데이터셋을 만들지 않고 시각 성능을 획기적으로 높인 멀티모달 LLM '콜라보(CoLLaVO)' '모아이(MoAI)' 2가지를 연속 개발했다.

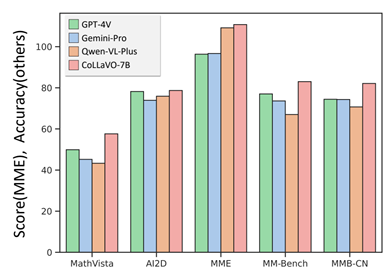

콜라보는 이미지 내 정보를 배경과 물체 단위로 분할하고 각 배경과 물체 정보를 멀티모달 LLM에 직접 입력하는 '크레용 프롬프트(Crayon Prompt)'를 새롭게 제안한 결과다.

또 물체 수준 이미지 이해 능력과 시각-언어 태스크 처리 능력을 서로 다른 파라미터로 학습해 서로 간 정보를 잃지 않게 만드는 학습 전략인 '듀얼 큐로라(Dual QLoRA)'도 담았다.

이로써 콜라보 멀티모달 LLM은 이미지 내에서 배경 및 물체를 구분하는 능력이 뛰어나 일차원적인 시각 구분 능력이 크게 향상됐다.

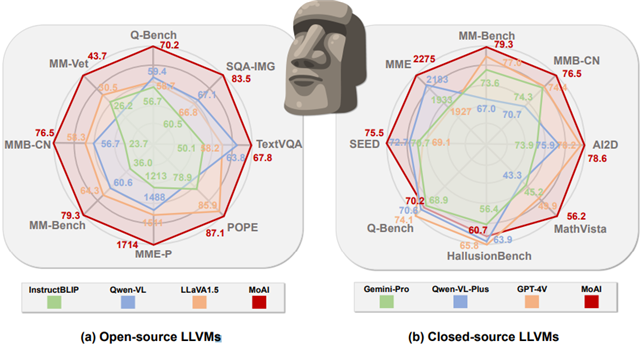

모아이(MoAI)는 인간이 사물을 판단할 때 물체의 존재와 상태 및 상호작용, 배경 이해, 텍스트 이해 등으로부터 상황을 판단하는 인지과학적인 요소에 영감을 받아 만들었다.

연구진은 기존 멀티모달 LLM이 텍스트에 의미적으로 정렬된 시각 인코더만을 사용해 이미지 픽셀 수준에서 상세하고 종합적인 실세계 장면 이해가 부족하다는 점을 지적하며, 컴퓨터 비전 모델 결과를 받으면 모두 인간이 이해할 수 있는 언어로 변환한 뒤 멀티모달 LLM에 입력해 직접 사용했다.

노용만 교수는 “연구팀에서 개발한 공개형 멀티모달 LLM이 '허깅페이스 일간 화제의 논문'에 추천됐고, 세계 연구자에 알려지고 있다”며 “모든 모델을 공개형으로 출시해 멀티모달 LLM 발전에 기여할 것”이라고 언급했다.

김영준 기자 kyj85@etnews.com