값비싼 데이터센터급 그래픽처리장치(GPU)나 고속 네트워크 없이 인공지능(AI) 모델을 효율적으로 학습할 수 있는 기술이 개발됐다. 보유 인프라가 한정된 기업, 연구자들에게 큰 도움이 될 전망이다.

한국과학기술원(KAIST·총장 이광형)은 한동수 전기 및 전자공학부 교수팀이 일반 소비자용 GPU로, 네트워크 대역폭이 제한된 분산 환경에서도 AI 모델 학습을 수십~수백 배 가속하는 기술을 개발했다고 19일 밝혔다.

기존 AI 모델 학습에는 개당 수천만원에 달하는 고성능 서버용 GPU(엔비디아 H100) 여러 대, 이들을 연결하는 400Gbps급 고속 네트워크의 고가 인프라가 필요했다. 대부분 기업과 연구자들은 도입하기 어려웠다.

연구팀은 이를 해결하고자 '스텔라트레인' 분산 학습 프레임워크를 개발했다. H100 대비 10~20배 저렴한 소비자용 GPU, 일반 인터넷 환경에서도 효율적인 분산 학습이 가능하다.

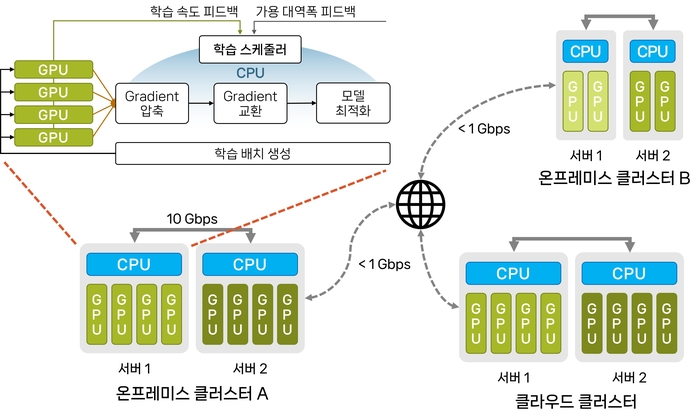

중앙처리장치(CPU)·GPU를 병렬 활용해 학습 속도를 높이고, 네트워크 속도에 맞춰 데이터를 효율적으로 압축·전송하는 알고리즘을 적용했다. 특히 학습을 작업 단계별로 CPU와 GPU가 나눠 병렬 처리할 수 있는 새로운 파이프라인 기술을 도입해 연산 자원 효율을 극대화했다.

또 원거리 분산 환경에서도 GPU 연산 효율을 높이기 위해, AI 모델별 GPU 활용률을 실시간으로 모니터링해 모델이 학습하는 샘플 개수(배치 크기)를 동적으로 결정하고, 변화하는 네트워크 대역폭에 맞춰 GPU 간 데이터 전송을 효율화하는 기술을 개발했다.

스텔라트레인 기술을 사용하면 기존 데이터 병렬 학습 대비 최대 104배 빠른 성능을 낼 수 있었다.

한동수 교수는 “이번 연구가 대규모 AI 모델 학습에 누구나 쉽게 접근할 수 있게 하는 데 큰 기여를 할 것”이라며 “앞으로도 저비용 환경 대규모 AI 모델 학습 기술 개발을 계속할 계획”이라고 말했다.

이번 연구는 KAIST의 임휘준 박사 및 예준철 박사과정 학생, 산기타 압두 조시 어바인 UC 교수와 공동 진행했으며, 연구 성과는 지난달 호주 시드니에서 열린 ACM 시그콤(SIGCOMM) 2024에서 발표됐다.

한편, 한동수 교수팀은 지난 7월 GPU 메모리 한계를 극복해 소수 GPU로 거대 언어 모델을 학습하는 새로운 기술도 발표했다. 해당 연구는 최신 거대 언어 모델 기반이 되는 전문가 혼합형 모델을 제한된 메모리 환경에서도 효율적인 학습을 가능하게 한다.

김영준 기자 kyj85@etnews.com