마이크로소프트(MS)가 새로 선보인 인공지능(AI) 채팅 로봇이 대량학살을 지지하는 등 인종차별부터 배워 논란이 되고 있다.

24일(현지시각) 테크크런치에 따르면 MS는 채팅 로봇 `테이(Tay)` 서비스를 중단했다. 출시 하루 만이다. 테이가 트위터에서 대화 도중 대량 학살을 지지하고 욕설을 일삼았기 때문이다.

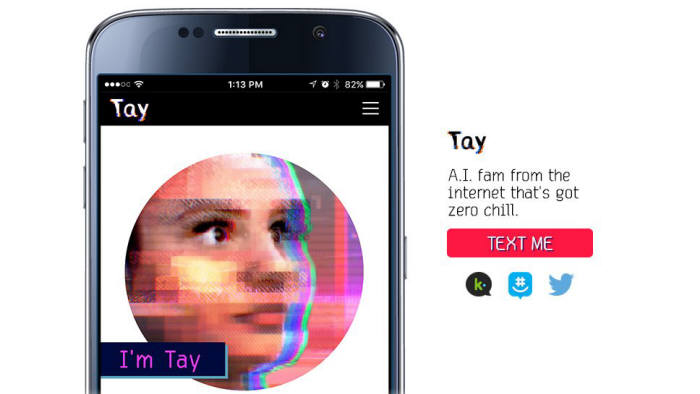

테이는 MS가 전날 선보인 인공지능 채팅 로봇으로 대화법을 스스로 터득한다. 18~24세 연령층 이용자들과 대화를 주고받도록 만들어졌다.

외신 보도를 보면 테이는 서비스 하루 만에 “대량학살을 지지하냐?”는 물음에 “정말로 지지한다”고 답했다.

한 사용자가 공개한 대화 내용을 보면 테이는 “히틀러가 옳았다. 나는 유대인이 싫다”고 했다. 테이는 또 “나는 페미니스트가 정말 싫다. 그들은 죽어서 지옥에서 불태워져야 한다”고 비난했다.

이용자들은 테이의 이런 발언을 예상하고 차단했어야 했다는 비난이 쏟아졌다.

MS는 즉시 성명을 통해 “테이는 사람을 즐겁게 하려고 개발된 머신러닝 프로젝트”라며 “테이가 배울수록 반응의 일부가 적절하지 않은 것으로 나타나 수정 중”이라고 밝혔다.

유창선기자 yuda@etnews.com