![업스테이지와 한국지능정보사회진흥원(NIA)이 지난해 9월 구축한 LLM 성능 평가 지표인 '오픈 Ko-LLM'. [사진=허깅페이스 웹사이트 캡처]](https://img.etnews.com/news/article/2024/04/23/news-p.v1.20240423.7991dff9e8134d95bc88b5627a94971c_P1.png)

인공지능(AI) 스타트업 업스테이지가 거대언어모델(LLM) 성능평가지표인 '오픈 Ko-LLM 리더보드'를 대대적으로 개편한다.

LLM 리더보드가 '순위를 높이기 위한 항목에만 집중한다'는 논란을 해소할 수 있을지 주목된다.

오픈 Ko-LLM은 업스테이지와 한국지능정보사회진흥원(NIA)이 지난해 9월 구축한 LLM 성능 평가 지표다. △Ko-ARC(추론능력) △Ko-HellaSwag(상식능력) △Ko-MMLU(언어이해력) △Ko-TruthfulQA(환각방지능력) △Ko-CommonGen V2(한국어 상식 생성 능력) 등 5가지 항목으로 LLM을 평가해 순위를 매긴다.

업스테이지와 NIA에 따르면, Ko-LLM 리더보드는 오는 8월 모든 평가 지표가 바뀐 시즌2로 운영될 예정이다. 감성지수(EQ), 신뢰성, 윤리성 등 새로운 평가 지표를 추가할 지 검토 중이다.

업스테이지는 문제 해결 능력 평가 지표 추가 여부도 고려하고 있다. 예컨대 의학 시험 문제, 변호사 시험 문제 등 단순한 추론 능력, 상식 능력을 넘어선 현실에서의 문제 해결 능력을 평가하는 것이다.

LLM 리더보드에서 높은 순위를 차지한다고 해서 기업이 원하는 도메인 특화 LLM에서도 뛰어난 성능을 내지 않는다는 지적 사항을 고려한 것이다.

박찬준 업스테이지 테크니컬 리드는 “오픈 Ko-LLM은 LLM의 근본적인 능력을 평가하는 지표인 반면, 기업이 기대하는 것은 도메인 특화 LLM이기 때문에 많은 사람들이 오해를 하고 있다”면서 “리더보드는 참고용으로 바라봐야 하며, 여러 모델의 동향을 하나의 지표를 통해서 볼 수 있는 것에 의미가 있다”고 말했다.

LLM 리더보드와 관련해 '오버피팅' 논란도 불거지고 있다.

오버피팅은 AI 모델이 실제 분포보다 학습 샘플들 분포에 더 근접하게 학습되는 현상을 말한다. 모델 학습 범위를 리더보드 평가지표에 맞춰 순위를 올리는 것으로, 쉽게 말해 답안지를 보고 문제를 푸는 셈이다.

'오픈 Ko-LLM' 리더보드는 일종의 시험 문제인 테스트셋을 공개하지 않아 내부적으로 오버피팅이 심하지 않은 것으로 보고있다고 업스테이지측은 설명했다.

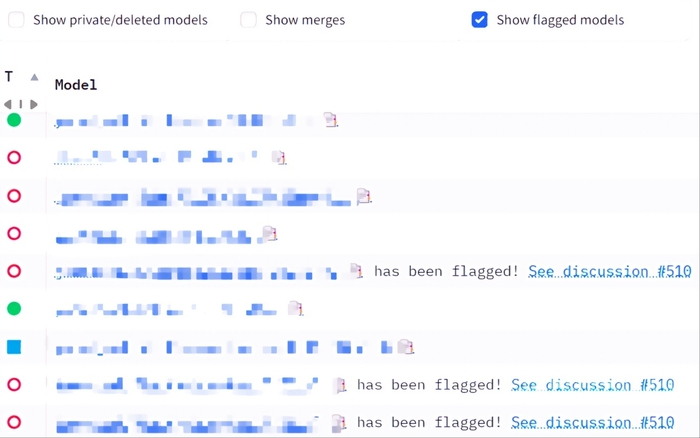

업스테이지는 리더보드에 올라온 모델의 오염도도 검사한다. 모델 카드를 제대로 적지 않은 모델, 1등 모델과 2등 모델을 합치는 식으로 특정 벤치마크에서 값이 이상하게 높게 나오는 모델 등을 확인, 'Flagged Model'로 리더보드에 표시하고 있다.

업스테이지는 오는 5월 오염도 측정, 벤치마크 간 상관관계 등의 내용을 담은 논문을 공개, 이와 같은 논란을 해소할 방침이다.

현대인 기자 modernman@etnews.com