모바일 플랫폼에 인공지능(AI) 시스템을 적용할 수 있는 딥러닝 반도체 칩이 개발됐다. 저전력 구동을 통해 스마트폰과 같은 소형 모바일 기기만으로 다양한 고성능 AI 기능을 실시간 구현할 수 있게 될 전망이다.

정보통신기술진흥센터(IITP·센터장 이상홍)는 유회준 KAIST 전기 및 전자공학부 교수팀이 모바일 플랫폼용 저전력 딥러닝 반도체 칩인 '딥 뉴럴 네트워크 프로세싱 유닛(DNPU)'를 개발했다고 28일 밝혔다.

딥러닝은 인간의 뇌 구조를 닮은 머신러닝(기계학습) 기술이다. 인공신경망으로 수많은 정보 속에서 패턴을 발견·학습하고, 사물을 구분하는 방식을 모방했다. 구글의 알파고도 딥러닝 기술을 활용했다. 회선신경망(CNN), 순환신경망(RNN)이 주된 인공신경망이다.

CNN은 시각화 정보 처리에 주로 쓰인다. 이미지를 통해 얼굴과 물체를 인식한다. RNN은 피드백 경로를 갖춘 뉴런으로 데이터 순차 처리 및 생성에 활용된다.

그동안 딥러닝 기술을 모바일 플랫폼에 적용하기 어려웠다. 수많은 데이터를 연산 처리하는데 고성능 컴퓨팅 환경이 필요, 전력 소모량이 많다.

연구팀은 반도체 칩을 자체 개발한 최적화 기술을 이용해 하나의 저전력 반도체 칩으로 CNN, RNN 기술을 구현할 수 있게 했다. 칩 안에 CNN, RNN 연산을 수행하는 각각의 가속기(전용 프로세서)를 최적화, 제작해 넣었다.

CNN 가속기는 외부 메모리 접근을 최소화하고 온칩 메모리를 주로 사용하는 방식으로 전력 소모를 줄였다. 처리 데이터를 세부 분할할 수 있도록 연산 과정을 최적화, 내부 온칩 메모리만으로 데이터를 저장할 수 있게 했다.

또 수많은 연산 레이어(층)의 출력을 다변화해서 세심한 최적화가 가능하게 했다. CNN 연산 레이어는 층별 출력이 획일화돼 있어 최적화에 한계가 있었다.

RNN 가속기는 반복 연산 결과를 내장 메모리에 저장해 필요할 때 불러올 수 있게 하는 방식을 썼다. 연산을 간소화하고 외부 메모리 접근을 줄여 에너지 효율을 높였다. DNPU의 에너지 효율은 알파고의 두뇌로 알려진 텐서플로프로세스유닛(TPU)보다 4배 높다.

DNPU는 지난 20~22일 미국 새너제이에서 열린 핫칩스 학회에 발표돼 주목받았다. 핫칩스 학회는 매년 세계 최고 수준의 기업, 대학이 반도체 칩을 발표하는 학회다.

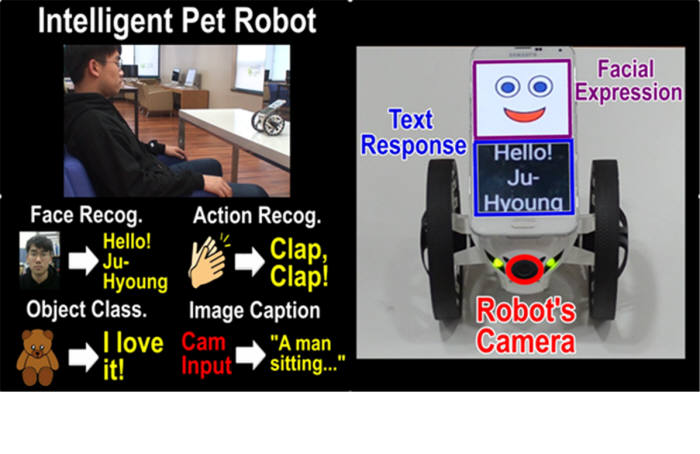

유회준 교수는 “DNPU는 물체 인식, 행동 인식, 이미지 캡셔닝 등 AI 기술을 저전력 실시간으로 구현할 수 있다”면서 “앞으로 스마트폰, 소형 로봇, 웨어러블 디바이스, 사물인터넷(IoT) 장치 등에 탑재할 수 있도록 상용화 연구를 진행하겠다”고 말했다.

대전=김영준기자 kyj85@etnews.com