미국의 매사추세츠 공대(MIT) 과학자들이 확장현실(XR) 기기 '애플 비전 프로'와 실물 로봇을 연동해 원격으로 로봇을 움직일 수 있는 애플리케이션(앱)을 개발해 선보였다.

15일(현지시간) 미국 과학 전문매체 라이브 사이언스에 따르면, 박영효 MIT 로보틱스 박사과정 대학원생은 지난 9일 엑스(X·옛 트위터)에서 자신이 개발한 앱 '트래킹 스트리머'를 이용해 애플 비전 프로를 쓰고 로봇을 제어하는 모습을 공개했다.

그가 트래킹 스트리머는 사람의 움직임, 특히 머리와 손목, 손가락의 움직임을 추적해 해당 데이터를 와이파이 등 같은 네트워크에 있는 로봇으로 스트리밍하는 앱이다. 연결된 로봇은 전달받은 데이터를 움직임으로 변환할 수 있다.

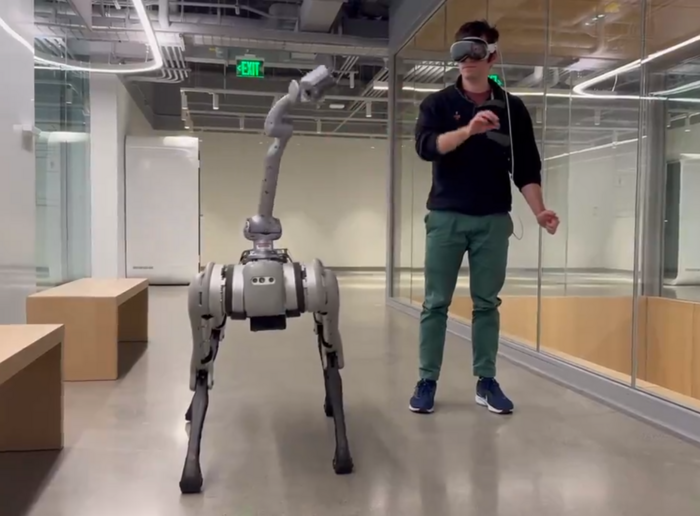

영상을 보면 그와 함께 앱을 개발한 게이브 마골리스 MIT 대학원생이 애플 비전 프로를 쓰고 손을 이리저리 움직이자 거의 동시에 로봇이 손의 움직임을 따라 한다.

이어 마골리스 연구원이 앉았다 일어났다를 하거나 다른 곳으로 이동해 손잡이를 잡고 문을 여는 모습까지 따라했다. 쓰레기통 뚜껑을 주워 쓰레기통에 얹는 등의 동작도 수행했다.

개발진은 이 앱에 대해 “애플 비전 프로는 사람의 동작을 통해 로봇 원격 조작이 용이하게 하는 기기”라며 “네트워크를 통해 추적 데이터를 스트리밍하고, 사용자가 장치에 의해 캡처된 자연스러운 제스처와 움직임을 사용하여 원격으로 로봇을 제어할 수 있게 돕는다”고 소개했다.

다만 손을 허리 아래로 내리거나 엉덩이 위에 올리는 경우 손에 대한 모션 캡처가 잘 되지 않는 등 해결해야 한 문제점도 남아있다. 향후 더 많은 데이터를 축적해 단계적으로 업그레이드하겠다는 설명이다. 현재 앱은 오픈 소스 플랫폼 깃허브에 공개된 상태다.

서희원 기자 shw@etnews.com