인공지능(AI) 가속기 시장을 독점한 엔비디아에 맞설 수 있을만한 고용량·고성능 AI 가속기 기술이 국내 개발됐다.

한국과학기술원(KAIST)은 정명수 전기 및 전자공학부 교수팀이 차세대 인터페이스 기술인 '컴퓨터 익스프레스 링크(CXL)'로 고용량 그래픽처리장치(GPU) 메모리 읽기·쓰기 성능을 최적화한 기술을 개발했다고 8일 밝혔다.

최신 거대언어모델(LLM) 학습에 수십 테라바이트 메모리가 요구되는 현 상황에서 유의미한 성과다.

최신 GPU 내부 메모리 용량은 수십 기가바이트(GB)에 불과해 단일 GPU로는 모델 추론·학습이 어렵다. 결국 GPU 여러 대를 연결하는 방식을 쓰는데 비용이 문제다.

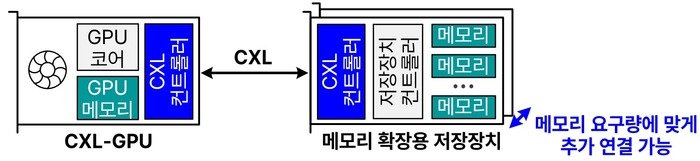

이에 대용량 메모리를 GPU에 연결해 고용량을 확보하는 'CXL-GPU' 구조 기술 활용이 각광받는다. 다만 GPU에 연결한 메모리 확장 장치 읽기·쓰기 성능을 기존 GPU 내부 메모리 수준으로 높이는 문제가 남는다.

연구진이 CXL-GPU 메모리 읽기·쓰기 성능 저하를 개선했다. 메모리 확장 장치가 메모리 쓰기 타이밍을 스스로 결정할 수 있게 했고, 확장 장치에 메모리 쓰기를 요청하는 동시에 GPU 내부 메모리에도 쓰기를 수행하도록 설계했다.

메모리 확장 장치가 내부 작업을 수행 상태에 따라 작업하도록 해, GPU가 메모리 쓰기 작업 완료 여부를 확인하는 데 드는 시간을 없앤 것이다.

또 연구진은 메모리 확장 장치가 사전에 메모리 읽기를 수행하도록 GPU 장치에 미리 '힌트'를 주는 기술도 개발했다. GPU가 캐시(작지만 빠른 임시 데이터 저장공간)에서 데이터를 읽어 더욱 빠른 읽기 성능을 달성할 수 있다.

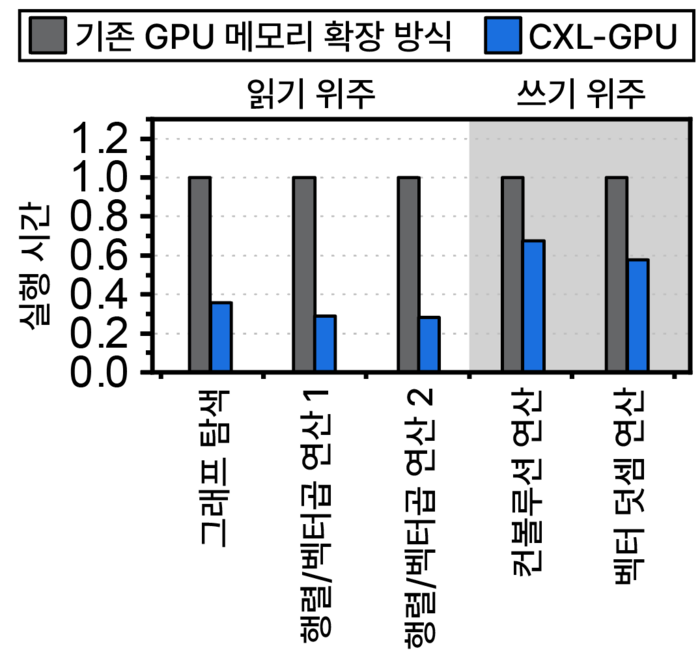

이번 연구는 반도체 팹리스 스타트업 '파네시아'의 초고속 CXL 컨트롤러, CXL-GPU 프로토타입을 활용해 진행됐다. 연구팀은 기존 GPU 메모리 확장 기술보다 2.36배 빠르게 AI 서비스를 실행할 수 있음을 확인했다. 이달 산타클라라 유즈닉스(USENIX) 연합 학회와 핫스토리지 연구 발표장에서 결과를 선보인다.

정명수 교수는 “CXL-GPU 시장 개화 시기를 가속해 대규모 AI 서비스 운영 빅테크 기업의 메모리 확장 비용을 획기적으로 낮추는 데 기여할 수 있을 것”이라고 말했다.

김영준 기자 kyj85@etnews.com