엔비디아가 차세대 고대역폭메모리(HBM)인 'HBM3E'를 탑재한 슈퍼 그래픽처리장치(GPU) 'GH200'을 내년 2분기 양산한다.

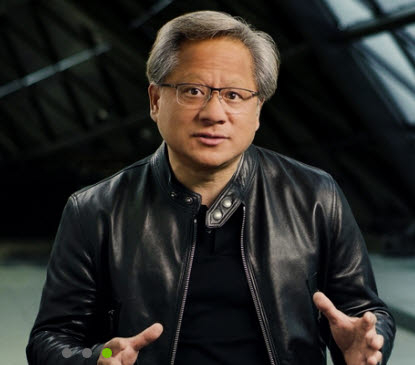

젠슨 황 엔비디아 최고경영자(CEO)는 8일(현지시간) 미국 로스앤젤레스(LA)에서 열린 '시그래프 2023' 행사에서 “생성형 인공지능(AI) 발전에 따라 컴퓨터그래픽(CG) 성능은 물론, AI 학습·추론·활용을 뒷받침할 고성능 하드웨어와 소프트웨어가 필요하다”며 이같이 밝혔다.

GH200은 그레이스 호퍼 슈퍼 칩이다. 엔비디아 인터커넥트 기술을 사용해 Arm 기반 엔비디아 그레이스 중앙처리장치(CPU)와 호퍼 GPU 아키텍처를 결합한 제품이다.

이전 세대인 HBM3을 탑재해도 사용할 수 있지만 GH200 성능을 극대화하기 위해서는 HBM3E가 적합하다는 게 엔비디아측 설명이다. 141GB HBM3E 메모리로 속도는 5TB/s 대역폭을 지원한다. AI 엔터프라이즈 특화된 GPU 'H100' 대비 1.7배의 캐퍼시티와 1.5배의 밴드위스(대역폭)를 보장한다.

GH200에 탑재될 HBM3E는 삼성전자와 SK하이닉스가 제공할 것으로 알려졌다. 삼성전자와 SK하이닉스는 엔비디아 등 늘어나는 글로벌 HBM 수요에 맞춰 HBM 생산능력(캐파)을 기존 대비 두 배 이상 늘리고 있다. GH200은 기업별 고유 데이터를 기반으로 하는 생성형 AI 애플리케이션 구축과 배포에 필요한 가속 컴퓨팅 인프라 지원에 특화됐다.

엔비디아는 손쉬운 생성형 AI 애플리케이션 설계와 서비스 구현을 위한 소프트웨어도 제공한다. 자연어 처리에 특화된 다양한 트랜스포머 모델과 학습 스크리트를 제공하는 모듈 '허깅 페이스'를 탑재한 플랫폼 '니모(NeMo)'를 지원한다. 기업별 최적화된 생성형 AI 애플리케이션 구축과 서비스 제공을 가능하게 하는 플랫폼이다. 생성형 AI 슈퍼컴퓨팅에 특화된 수백만명 개발자를 연결해준다.

마누빅 다스 엔비디아 수석부사장(VP)은 “AI 학습에 다양한 시나리오가 있고 학습 횟수에 따라 결과물도 달라질 수밖에 없다”며 “엔비디아는 클라우드, PC, 데이터센터, 워크스테이션 등 다양한 디바이스나 환경에서 생성형 AI 개발과 활용에 최적화된 소프트웨어와 하드웨어를 지원할 것”이라고 말했다.

한편 엔비디아는 Ada 세대 GPU를 탑재한 전문가용 시각 컴퓨팅 플랫폼 RTX 시리즈 신규 제품을 공개했다. 데이터센터에 특화 GPU 'L40s'도 선보였다. 서버용 GPU로 이미지·영 랜더링, 인퍼런스 등 속도가 이전 세대 GPU 대비 1.5배~4배 빨라진다.

박종진 기자 truth@etnews.com